출처 : http://jp.techcrunch.com/2018/03/02/2018-03-01-googles-new-youtube-stories-feature-lets-you-swap-out-your-background-no-green-screen-required/

Google의 연구자들은 사람들이 타인을 속이는 (다마)하여 지금 자신은 달에있는, 생각하게하고, 지금은 낮이 아니라 밤이라고 보이게 좋아하다고 알고있다. 그러나 그런 즐거운 장난은 영화 스튜디오든지 가서 그린 스크린 앞에서 촬영하지 않으면 실현은 어렵다. 그래서 2018 년의 우수한 프로그래머들은 자신들이 할 수있는 한 : 신경망을 이용하여 할거야 것이다.

그 "비디오 세분화"(동영상 잘라)라는 도구는 모바일에서 YouTube Stories에서 오늘 (미국 시간 3/1)에서 일부 사용자에게 배포된다. 화면에이 옵션이 있다면, 축하합니다, 당신은 베타 테스터이다.

이 기능은 다양한 궁리가 포함되어있는 것 같다. 전경 (피사체 본체)와 배경의 경계를 찾아야한다,하지만 iPhone X 전면 카메라 배열과 같은 깊이 (z 축 방향)을 감지하는 카메라와 대량의 처리 시간과 배터리보다 장시간 사용할 수있는 전원이 있으면 식은 죽 먹기 다. 이렇게, 데스크톱 컴퓨터를 사용하면된다.

하지만 모바일 게다가 보통의 RGB 이미지 (깊이 정보가없는)이되면, 그렇게 쉬운 일이 아니다. 스틸 이미지도 어려운데 비디오가되면 더욱 그렇다. 컴퓨터 배경 검출을위한 계산을 적어도 초당 30 회하지 않으면 안된다.

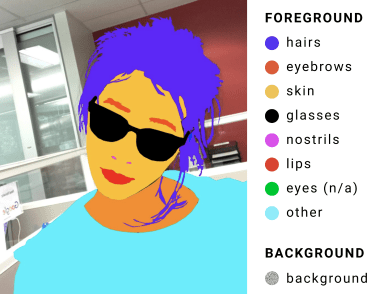

이렇게, Google의 기술자들도 그것을 도전이라고 파악했다 . 회선 신경망을 설정하고 그것을 수천의 레이블 이미지 (그 예가 오른쪽 그림)에서 훈련했다.

그 신경망은 사람의 머리와 어깨와 같은 일반적인 특징을 찾을 수 있도록 훈련 된 일련의 최적화에 의해 정확한 탐지를 위해 필요한 데이터의 양을 줄여 나갔다. 또한 이전 계산의 결과 (머리 자르기 등)을 다음을위한 소재로 사용하는 일종의 컴퓨터 속이 의해 계산 부하를 더 숙였다.

그 결과, 고속화면서도 비교적 정확한 세분화 엔진을 얻을 수있어 비디오에 대해서도 사용할 수있을만큼의 속도를 달성했다